در دنیای سئو، یکی از چالشهایی که ممکن است وبمسترها با آن روبهرو شوند، خطاهای مختلف در گوگل سرچ کنسول است. دو خطای رایج که ممکن است باعث سردرگمی شوند، عبارتند از Blocked by robots.txt و Indexed, though blocked by robots.txt.

با ما همراه باشید تا در این مقاله، با این خطاها و بررسی روشهای موثر برای رفع آنها آشنا شوید.

در دنیای پیچیده سئو و بهینهسازی موتورهای جستجو، فایل robots.txt نقش کلیدی در کنترل دسترسی رباتهای خزنده به صفحات وب ایفا میکند. این فایل متنی ساده، قوانینی را برای رباتها تعیین میکند تا مشخص شود کدام بخشهای سایت برای عموم قابل مشاهده است و کدام قسمتها باید از ایندکس خارج شوند. اما گاهی اوقات، ممکن است با دو خطای رایج در گوگل سرچ کنسول مواجه شویم: "Blocked by robots.txt" و "Indexed, though blocked by robots.txt". این دو خطا، هرچند به ظاهر شبیه به هم هستند، اما دلایل و پیامدهای متفاوتی دارند.

در این مقاله، قصد داریم به بررسی دقیق این دو خطا پرداخته و تفاوتهای آنها را به صورت ساده و قابل فهم تشریح کنیم. همچنین، راهکارهایی برای رفع هر یک از این خطاها و بهبود عملکرد سایت در نتایج جستجو ارائه خواهیم داد. با ما همراه باشید تا به درک عمیقتری از این دو خطا و اهمیت آنها در سئو دست پیدا کنید.

در گوگل سرچ کنسول دو خطای Blocked by robots.txt و Indexed, though blocked by robots.txt ممکن است به نمایش درآیند که هر دو نشان میدهند صفحات شما به دلیل محدودیتهای موجود در فایل robots.txt برای رباتهای گوگل مسدود شدهاند.

با این حال، این دو خطا تفاوتهای مهمی دارند که در ادامه به آنها میپردازیم:

Blocked by robots.txt:

صفحات با این خطا در نتایج جستجو نمایش داده نخواهند شد و به همین دلیل، اطلاعات آنها برای رتبهبندی در گوگل در دسترس نخواهد بود.

Indexed, though blocked by robots.txt:

برخلاف خطای قبلی، در این وضعیت گوگل صفحه شما را ایندکس کرده است، اما به دلیل محدودیتهایی که در فایل robots.txt وجود دارد، نتوانسته محتوای آن را بررسی کند. به عبارت دیگر، این صفحات ممکن است در نتایج جستجو ظاهر شوند، حتی اگر گوگل نتواسته محتوای آنها را بخزد. این وضعیت معمولاً زمانی رخ میدهد که گوگل بتواند برخی اطلاعات پایه مانند عنوان صفحه، متا دیتا یا لینکهای داخلی را از آن صفحه شناسایی کند، بدون اینکه محتوای کامل آن بررسی شود.

فایل robot.txt چیست؟

فایل robots.txt یک فایل متنی است که به شما این امکان را میدهد تا کنترل کنید رباتهای گوگل کدام صفحات سایت شما را خزیده و از کدام بخشها بازدید نکنند. زمانی که شما دستور Disallow را در این فایل قرار میدهید، به گوگل اعلام میکنید که نباید به صفحاتی که این دستور را دارند دسترسی پیدا کند.

با این حال، باید توجه داشته باشید که robots.txt تنها برای کنترل فرآیند خزیدن کاربرد دارد و قادر به کنترل ایندکس شدن صفحات نیست. یعنی حتی اگر رباتها نتوانند صفحهای را خزیده یا بررسی کنند، گوگل ممکن است آن صفحه را ایندکس کند.

ارتباط robots.txt با ایندکس صفحات

قبل از اینکه یک صفحه در نتایج جستجو ایندکس شود، خزندههای موتورهای جستجو ابتدا باید آن صفحه را شناسایی کرده و سپس آن را بررسی کنند.

در مرحله اول، خزنده متوجه میشود که یک URL خاص وجود دارد. در طول فرایند خزیدن، ربات گوگل به این URL مراجعه کرده و اطلاعاتی از محتوای آن جمعآوری میکند. پس از این مرحله، URL برای ایندکس شدن به گوگل ارسال میشود و در نهایت میتواند در نتایج جستجوی گوگل نمایش داده شود.

خطای Blocked by robots.txt در سرچ کنسول چیست؟

این خطا نشاندهنده این است که گوگل نتوانسته صفحه مورد نظر را بخزد، زیرا دسترسی آن با دستور Disallow در فایل robots.txt مسدود شده است. این به معنای آن است که URL مورد نظر ایندکس هم نشده است.

محدود کردن خزیدن برخی از URL ها میتواند منطقی باشد، به ویژه زمانی که سایت شما اندازه بزرگی دارد. برخی صفحات به طور طبیعی نباید در نتایج جستجو ظاهر شوند.

انتخاب صفحاتی که باید یا نباید خزیده شوند، بخش اساسی و مهمی در ایجاد استراتژیهای ایندکس وب سایت شماست.

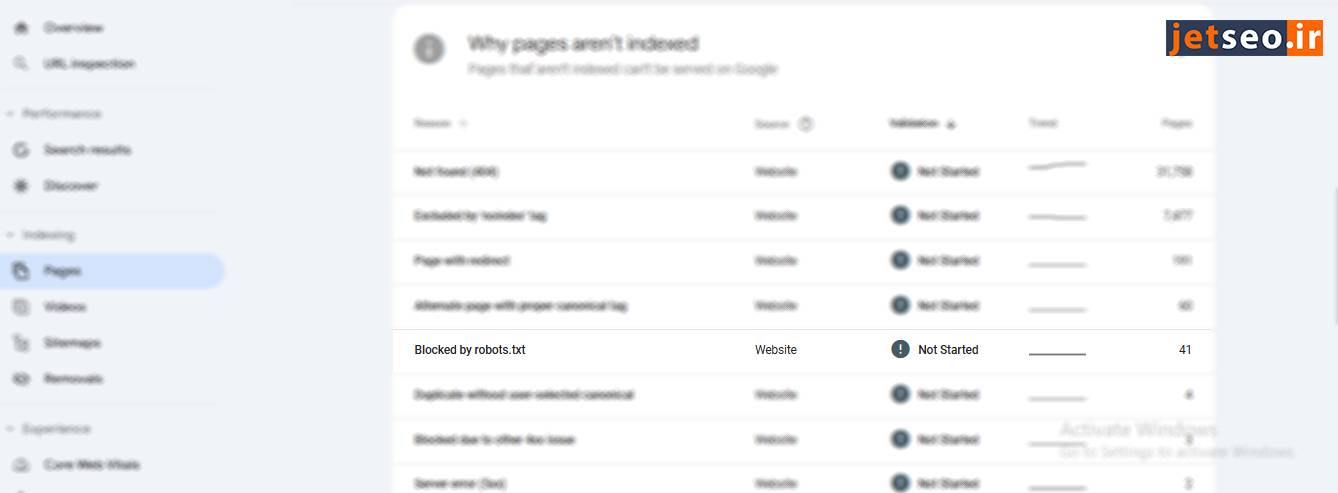

برای بررسی صفحات Blocked by robots.txt ابتدا به page indexing در سرچ کنسول بروید و در جدول “Why pages aren’t indexed” خطای Blocked by robots.txt رو پیدا کنید.

علت خطای Blocked by robots.txt در سرچ کنسول

مهمترین دلیل بروز این خطا عدم پیکربندی صحیح فایل robots.txt است. ممکن است وبمستران به اشتباه دستوری را در این فایل قرار داده باشند که به رباتهای جستجو اجازه دسترسی به محتوای مهم وبسایت را نمیدهد. برای مثال، اگر به طور ناخواسته کل دایرکتوری را مسدود کنید، تمام صفحاتی که در آن دایرکتوری قرار دارند از ایندکس خارج خواهند شد.

علاوه بر این، برخی وبسایتها به دلایل امنیتی و حفظ حریم خصوصی، فایل robots.txt را به گونهای تنظیم میکنند که رباتها نتوانند به برخی از صفحات یا دایرکتوریها دسترسی داشته باشند. این عمل میتواند منجر به کاهش سرعت ایندکسسازی و در نتیجه آسیب به سئوی سایت شود.

حل خطای Blocked by robots.txt در سرچ کنسول

برای حل این مشکل، دودیدگاه مختلف وجود دارد:

-

زمانی که قصد دارید صفحه ایندکس شود

-

زمانی که قصد ندارید صفحه ایندکس شود

در ادامه، به توضیح اقدامات لازم برای حل هر یک از این موارد میپردازیم :

زمانی که قصد دارید صفحه ایندکس شود:

برای رفع خطای Blocked by robots.txt، باید دستور Disallow که مانع از خزیدن صفحه شده را از فایل robots.txt حذف کنید.

با انجام این تغییر، گوگل معمولاً در دفعات بعدی که سایت شما را بخزد، به سراغ آن صفحه نیز میرود. اگر هیچ مشکل دیگری وجود نداشته باشد، صفحه برای ایندکس شدن آماده میشود.

زمانی که قصد ندارید صفحه ایندکس شود:

شما میتوانید وضعیت Blocked by robots.txt در گوگل سرچ کنسول را نادیده بگیرید اگر واقعا قصد ایندکس صفحهای را ندارید، البته به شرطی که هیچ URL ارزشمندی در فایل robots.txt خود مسدود نکرده باشید.

فراموش نکنید که مسدود کردن رباتها از خزیدن به صفحات با محتوای کمکیفیت یا تکراری کاملاً طبیعی است و حتی میتواند به بهبود سئوی سایت شما کمک کند.

خطای indexed though blocked by robots.txt در سرچ کنسول چیست؟

گاهی اوقات گوگل تصمیم میگیرد که یک صفحه را با وجود اینکه نمیتواند آن را بخزد و محتوایش را درک کند، ایندکس کند.

این اتفاق معمولاً زمانی میافتد که لینکهای زیادی به صفحه مسدود شده اشاره دارند، بنابراین گوگل انگیزه پیدا میکند که بدون خزیدن، آن صفحه را ایندکس کند.

لینکها به اعتبار PageRank تبدیل میشوند و گوگل از آنها برای ارزیابی اهمیت صفحه استفاده میکند. الگوریتم PageRank به هر دو نوع لینکهای داخلی و خارجی توجه میکند.

وقتی لینکسازی سایت شما بدون برنامهریزی انجام شود و گوگل متوجه شود که یک صفحه غیرمجاز دارای PageRank بالایی است، احتمالاً فکر میکند که آن صفحه بسیار مهم است و باید آن را در نتایج جستجو نمایش دهد.

با این حال، این ایندکس تنها شامل یک URL بدون محتوای واقعی است، چرا که محتوا خزیده نشده است.این موضوع میتواند به سئو سایت آسیب زیادی وارد کند.

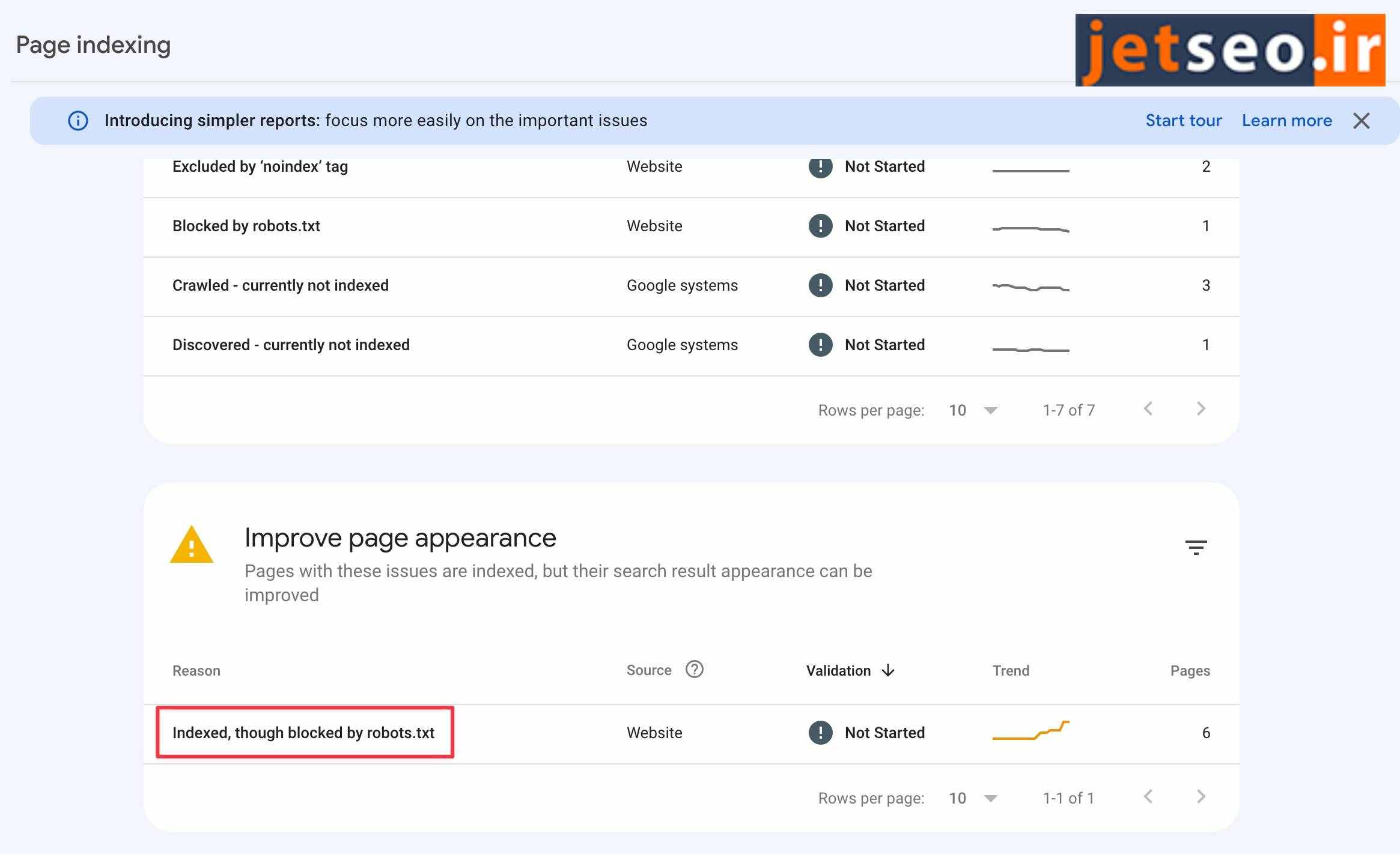

برای بررسی صفحات indexed though blocked by robots.txt ابتدا به page indexing در سرچ کنسول بروید و در جدول Why pages aren’t indexed خطای indexed though blocked by robots.txt رو پیدا کنید.

علاوه بر بررسی در سرچ کنسول، میتوانید با استفاده از ابزارهای آنلاین و یا حتی آدرس «robots.txt» سایت خود، به احتمال وجود محدودیتها پی ببرید. با وارد کردن آدرس www.yoursite.com/robots.txt در مرورگر، میتوانید محتوای این فایل را مشاهده و بررسی کنید.

علت تأثیر منفی "Indexed, though blocked by robots.txt" بر سئو

وضعیت Indexed, though blocked by robots.txt میتواند یک مشکل جدی باشد و سئو سایت شما را از چند جنبه مختلف تحت تاثیر قرار دهد:

صفحاتی که بدون خزیدن ایندکس میشوند، در نتایج جستجو جذابیت چندانی ندارند، زیرا گوگل قادر به نمایش اطلاعات مهم زیر نخواهد بود:

-

تگ عنوان (گوگل معمولاً از URL صفحه و اطلاعاتی که از صفحاتی که به آن لینک دادهاند میگیرد، یک عنوان ایجاد میکند.)

-

توضیحات متا

-

هرگونه داده اضافی برای نتایج غنی

بدون این عناصر، کاربران نمیتوانند به راحتی بفهمند که پس از ورود به صفحه چه محتوایی انتظارشان را میکشد. این امر میتواند باعث شود که آنها سایتهای رقیب را انتخاب کنند، که در نهایت منجر به کاهش چشمگیر CTR و در نتیجه باعث افت سئو سایت شما میشود.

یکی دیگر از جنبه های منفی ارور Indexed, though blocked by robots در سرچ کنسول این است که اگر به طور عمدی از دستور Disallow در فایل robots.txt برای مسدود کردن دسترسی رباتها به یک صفحه خاص استفاده کردهاید، هدف شما جلوگیری از نمایش آن صفحه در نتایج جستجوی گوگل است. برای مثال، ممکن است هنوز در حال تکمیل محتوای صفحه باشید و آن را برای نمایش عمومی آماده نکرده باشید.

اما اگر این صفحه ایندکس شود، کاربران میتوانند آن را پیدا کرده و وارد کنند، که ممکن است منجر به تجربهای منفی برای آنها شده و در نهایت اعتبار وبسایت شما را تحت تأثیر قرار دهد.

رفع خطای indexed though blocked by robots.txt در سرچ کنسول

قبل از اقدام به حل مشکل indexed though blocked by robots.txt ، ابتدا بررسی کنید که آیا URLهای موجود در لیست واقعاً باید ایندکس شوند یا خیر. آیا محتوای آنها میتواند برای بازدیدکنندگان شما مفید و ارزشمند باشد؟

زمانی که قصد ایندکس صفحه را دارید:

اگر به اشتباه صفحهای در فایل robots.txt مسدود شده باشد، باید فایل را اصلاح کنید.

با حذف دستور Disallow که مانع خزیدن URL میشود، ربات گوگل در بازدید بعدی از وبسایت شما، به طور خودکار آن صفحه را خزیده و بررسی میکند.

زمانی که قصد ایندکس صفحه را ندارید:

اگر صفحهای حاوی اطلاعاتی باشد که نمیخواهید کاربران از طریق موتور جستجو مشاهده کنند، باید به گوگل اعلام کنید که نمیخواهید آن صفحه ایندکس شود.

فایل robots.txt برای کنترل ایندکس صفحات مناسب نیست، زیرا این فایل تنها از خزیدن رباتهای گوگل جلوگیری میکند. برای مدیریت ایندکس صفحات، باید از تگ noindex استفاده کنید.

توجه داشته باشید که باید به گوگل اجازه دهید صفحه را خزیده تا تگ noindex را شناسایی کند.اگر تگ noindex را اضافه کنید اما همچنان صفحه را در robots.txt مسدود نگه دارید، گوگل قادر به شناسایی تگ نخواهد بود و صفحه تحت وضعیت "Indexed, though blocked by robots.txt" باقی میماند.

زمانی که گوگل صفحه را خزیده و تگ noindex را مشاهده کند، آن را از نتایج جستجو حذف خواهد کرد.

اگر قصد دارید صفحهای را به طور کامل از دسترس گوگل و کاربران خارج کنید، امنترین روش استفاده از احراز هویت HTTP روی سرور است. با این کار، فقط کاربرانی که وارد سیستم شدهاند میتوانند به آن صفحه دسترسی پیدا کنند. این روش به ویژه زمانی که میخواهید دادههای حساس را محافظت کنید، توصیه میشود.

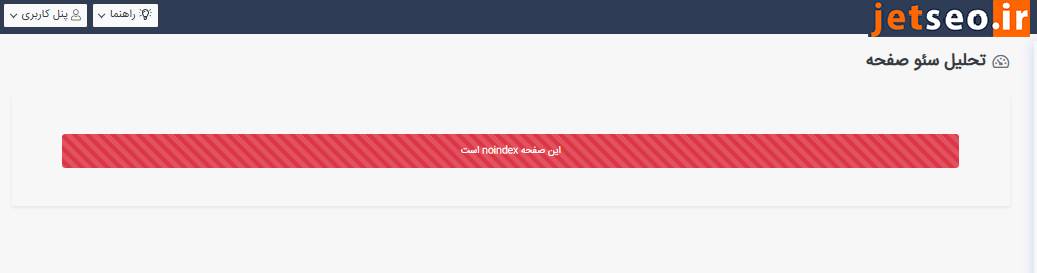

چگونه میتوانیم تشخیص دهیم کدام صفحات سایت noindex هستند؟

در سرچ کنسول، صفحاتی که تگ noindex دارند، تحت پیغام Excluded by ‘noindex’ tag در بخش صفحات نمایش داده میشوند. با این حال، تمامی صفحات با تگ noindex در سرچ کنسول نمایش داده نمیشوند. برای شناسایی تمام این صفحات، باید از ابزارهای سئو استفاده کنید که سایت را به طور کامل خزیده و خطاهای سئو و موارد مهم را به شما اطلاع میدهند.

در ابزار جت سئو این امکان برای شما فراهم شده است که هر زمان نیاز داشتید، کراولرهای جت سئو را برای بررسی سایت ارسال کنید و متوجه شوید که در کدام صفحات از تگ noindex استفاده شده است.

کافی است لینک صفحه مورد نظر را در قسمت تحلیل صفحه وارد کنید. همانطور که در تصویر زیر مشاهده میکنید، اگر این صفحه دارای تگ noindex باشد، جت سئو آن را برای شما نمایش میدهد.

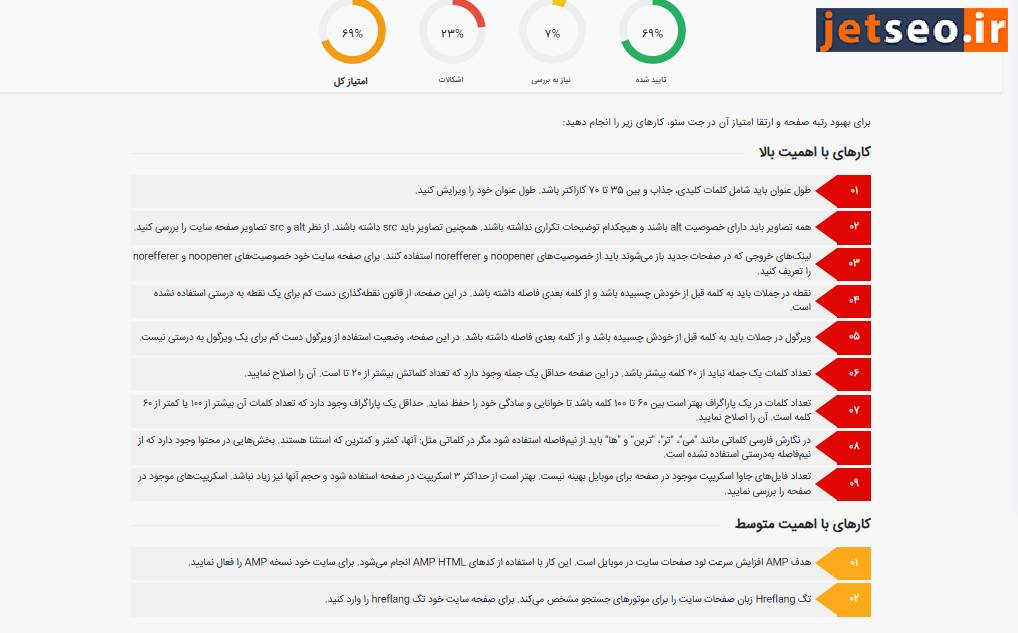

اگر این صفحه تگ noindex نداشته باشد به تحلیل صفحه میپردازد. این تحلیل شامل بررسی کلی صفحه از نظر لینکهای خروجی، بررسی ایرادات نگارشی محتوا، لینکهای داخلی، خصوصیت تصاویر و ... میباشد.

جمع بندی

در نهایت، تفاوت اصلی بین دو خطای Blocked by robots.txt و Indexed, though blocked by robots.txt در سرچ کنسول این است که اولی نشان میدهد صفحه بهطور کامل مسدود شده و نه تنها ایندکس نشده بلکه خزش هم در صفحه اتفاق نیفتاده است، در حالی که دومی به این معنی است که گوگل توانسته صفحه را ایندکس کند، اما به دلیل مسدود بودن خزیدن، محتوا را تحلیل نکرده است. رفع این مشکلات نیازمند بررسی دقیق فایل robot.txt و تنظیمات مربوط به خزیدن و ایندکس صفحات است. در مواقعی که صفحهای نباید ایندکس شود، استفاده از تگ noindex به جای دستور disallow در robots.txt توصیه میشود تا از ایندکس شدن صفحات بدون محتوای کامل جلوگیری شود و تجربه بهتری برای کاربران فراهم گردد.

ممنون که تا انتهای این مقاله از جت سئو با ما همراه بودید. مشتاق دریافت نظرات و سوالات شما هستیم.